择要:AI产物开发者需要先行一步,早一些让用户体验本身的产物,及用户成立毗连,造就粘性,从而于竞争中占患上先机。

2024注定是AI行业热闹特殊的一年。虽然方才进入3月份,可是关在AI的新闻已经经屡次盘踞了头条。就于上个月,OpenAI发布了文字天生视频的年夜模子Sora,其传神的效果直接清空了于这个细分赛道苦苦耕作的创业者。几天后,英伟达市值站上2万亿美元,成了汗青上最快实现从1万亿到2万亿美元市值的企业。正所谓“当你发明金矿,最佳的买卖不是挖矿而是卖铲子”,英伟告竣为了AI时代“武备竞赛”的最年夜赢家。

就于各人感叹“世界上只有两种AI,一种叫OpenAI,一种叫其他AI”的时辰,寂静了许久的Anthropic放出王炸,这家由OpenAI前研究副总裁创建的公司,发布了最新的Claude3模子,各项指标已经经周全逾越了GPT4。

AI行业的汹涌澎拜,也明示了这个行业还有处于一个低级阶段。技能迭代太快,暂时领先的企业可能于一晚上之间就被新技能倾覆。一些目炫狼籍的新技能,虽然已经经问世,但迟迟不公然或者者没有部署。好比上文提到的Sora,截至发文,还有没有正式向公家开放。

天生式AI的研发及当地部署之间存于鸿沟。今朝,公共利用的天生式AI产物往往是部署于云端而于当地拜候(好比ChatGPT网页),但这没法满意所有需求,而且会孕育发生一些隐患。

起首,跟着年夜模子愈来愈繁杂,云端及当地之间的传输于有限带宽下变患上捉襟见肘,好比一架波音787飞机每一秒钟孕育发生5G的数据,假如上传到云端、计较、输出成果再返回,飞机可能已经经飞出去几千米了(根据800千米/小时估算)。假如于飞机上利用AI功效可是于云端部署,如许的传输速率是没法满意要求的。

此外,一些用户敏感数据、隐私数据,是否必然要上云?显然放于当地比云端更让用户安心。

岂论天生式AI何等强盛,怎样部署到当地始终是一个没法绕开的问题。这是行业成长的趋向,虽然今朝面对一些坚苦。

坚苦于在,怎样把“年夜模子”装入“小装备”。留意,这里的“巨细”是相对于而言的。云端计较的暗地里多是一个占地几万平方米的计较中央,而当地部署却要让天生式AI于你的手机上跑起来。手机没有液氮冷却,也没有没有穷无尽的电力,该怎样部署AI呢?

异构计较,一种可能的解决方案?

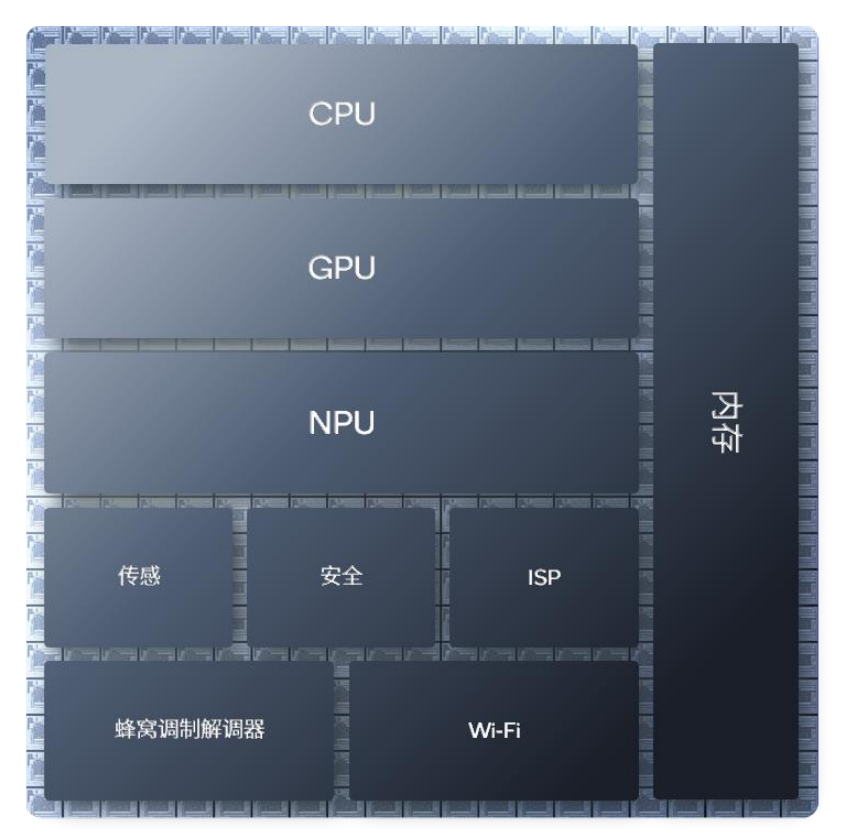

高通的异构计较AI引擎(如下皆称作高通AI引擎)为行业提供了一种可行的解决方案。即经由过程CPU、GPU、NPU以和高通传感器中枢及内存子体系的协作,实现了AI部署及年夜幅度晋升AI体验的目的。

图:专门的工业设计让差别计较单位更紧凑 来历:高通

差别类型的处置惩罚器所擅长的事情差别,异构计较的道理就是让“专业的人做专业的事”。CPU擅长挨次节制,合用在需要低延时的运用场景,同时,一些较小的传统模子如卷积神经收集模子(CNN),或者一些特定的年夜语言模子(LLM),CPU处置惩罚起来也能驾轻就熟。而GPU更擅长面向高精度格局的并行处置惩罚,好比对于画质要求很是高的视频、游戏。

CPU及GPU出镜率很高,公共已经经相称认识,而NPU相对于而言更像一种新技能。NPU即神经收集处置惩罚器,专门为实现低功耗、加快AI推理而打造。当咱们于连续利用AI时,需要以低功耗不变输出岑岭值机能,NPU就能够阐扬最年夜上风。

举个例子,当用户于玩一款重负载的游戏,此时GPU会被彻底占用,或者者用户于阅读多个网页,CPU又被彻底占用。此时,NPU作为真实的AI专用引擎就会承担起及AI有关的计较,包管用户的AI体验流利。

总结起来讲就是,CPU及GPU是通用场理器,为矫捷性而设计,易在编程,本职事情是卖力操作体系、游戏及其他运用。NPU则为AI而生,AI是它的本职事情,经由过程捐躯部门易编程特征而实现了更高的峰值机能及能效,一起为用户的AI体验护航。

当咱们把 CPU、GPU、NPU 以和高通传感器中枢及内存子体系集成于一路,就是异构计较架构。

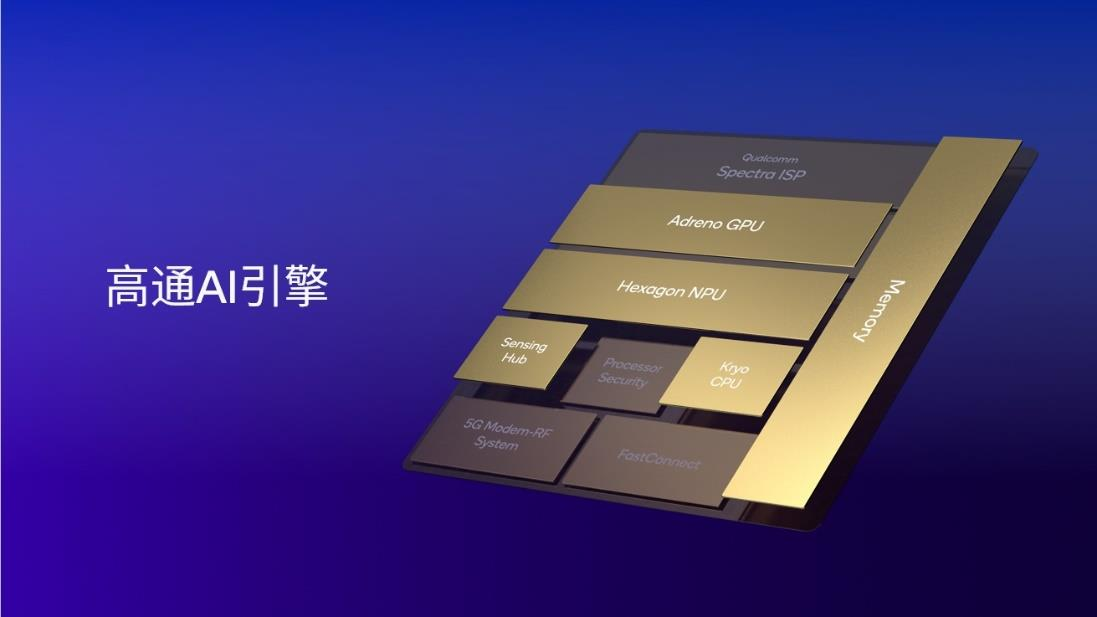

图:高通AI引擎包括Hexagon NPU、Adreno GPU、高通Oryon或者 Kryo CPU、高通传感器中枢及内存子体系 来历:高通

高通AI引擎整合了高通 Oryon 或者 Kryo CPU、 Adreno GPU 、 Hexagon NPU 以和高通传感器中枢及内存子体系。Hexagon NPU作为此中的焦点组件,颠末多年的进级迭代,今朝已经到达业界领先的AI处置惩罚程度。以手机平台为例,集成高通 AI 引擎的第三代骁龙 8 撑持行业领先的LPDDR5x内存,频率高达4.8GHz,使其可以或许以很是高速的芯片内存读取速率运行年夜型语言模子,如百川、Llama 2等,从而实现很是快的token天生速度,为用户带来全新的体验。

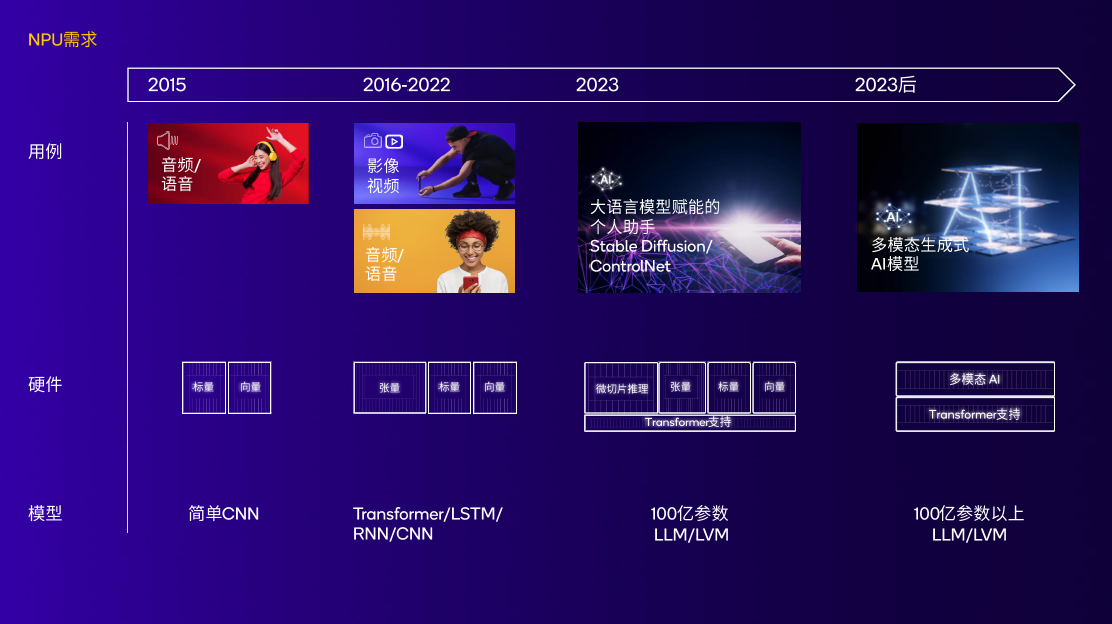

图:NPU跟着不停变化的AI用例及模子连续演进,实现高机能低功耗 来历:高通

高通对于NPU的研究,其实不是近几年才最先的。假如要追溯Hexagon NPU的发源,要回到2007年,也就是天生式AI走入公家视线的15年前。高通发布的首款Hexagon DSP于骁龙平台上表态,DSP节制及标量架组成为了高通将来多代NPU的基础。

8年后,也就是2015年,骁龙820处置惩罚器集成为了首个高通AI引擎;

2018年,高通于骁龙855中为Hexagon NPU增长了张量加快器;

2019年,高通于骁龙865上扩大了终端侧AI用例,包括AI成像、AI视频、AI语音等功效;

2020年,Hexagon NPU迎来厘革型架构更新。标量、向量、张量加快器交融,这为高通将来的NPU架构奠基了基础;

2022年,第二代骁龙8中的Hexagon NPU引入了一系列庞大技能晋升。微切片技能晋升了内存效率,功耗降低继承降低而且实现了4.35倍的AI机能晋升。

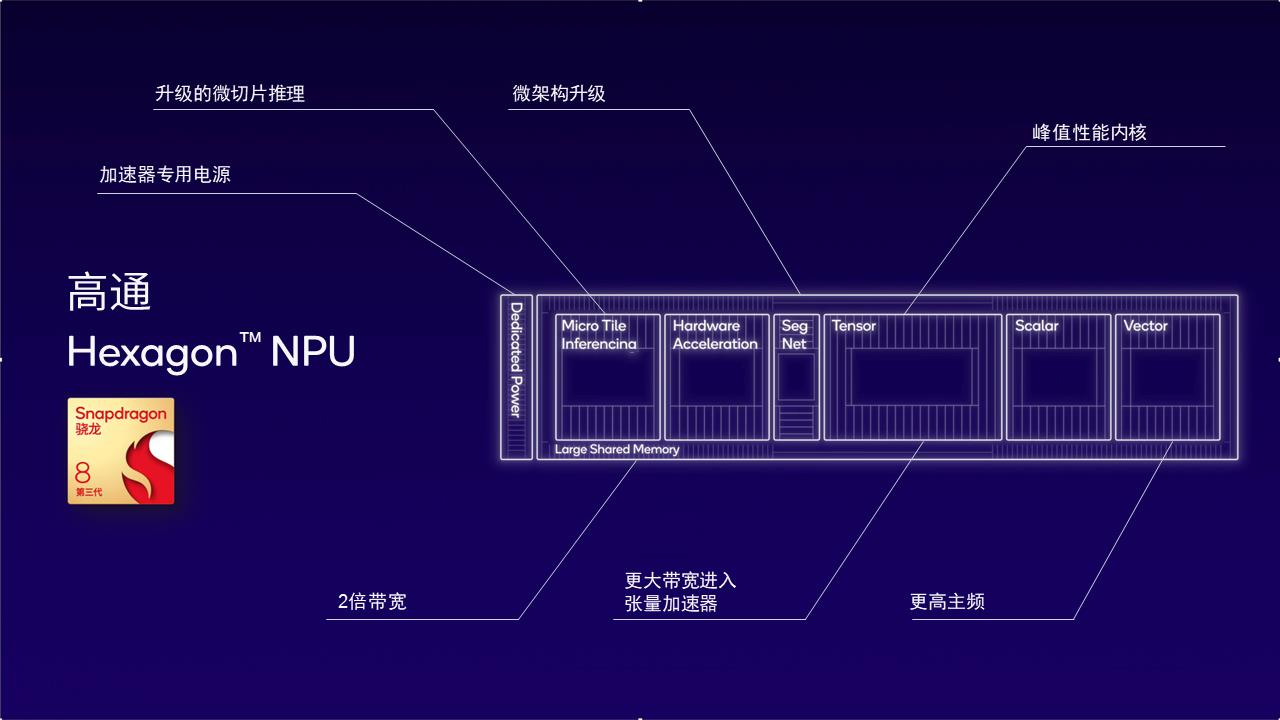

2023年10月25日,高通正式发布第三代骁龙8。作为高通技能公司首个专为天生式AI而精心打造的挪动平台,其集成的Hexagon NPU是今朝高通面向天生式AI最新、也是最佳的设计。

因为高通为AI开发者及下流厂商提供的是全套解决方案(这部门内容会于第三部门具体叙述),并不是零丁提供芯片或者者某个软件运用。这象征着于硬件设计上及优化上,高通可以全盘思量,找出今朝AI开发的瓶颈,做有针对于性地晋升。

好比,为什么要尤其于意内存带宽这个技能点?当咱们把视角从芯片上升到AI年夜模子开发,就会发明内存带宽是年夜语言模子token天生的瓶颈。第三代骁龙8的NPU架构之以是能帮忙加快开发AI年夜模子,缘故原由之一便于在专门晋升了内存带宽的效率。

这类效率的晋升重要受益在两项技能的运用。

第一是微切片推理。经由过程将神经收集支解成多个自力履行的微切片,消弭了高达10余层的内存占用,此举最年夜化使用了Hexagon NPU中的标量、向量及张量加快器并降低功耗。第二是当地4位整数(INT4)运算。它能将INT4层及神经收集及张量加快吞吐量提高一倍,同时晋升了内存带宽效率。

图:第三代骁龙8的Hexagon NPU以低功耗实现更佳的AI机能

2月26日,世界挪动通讯年夜会(MWC 2024)于巴塞罗那拉开帷幕。基在骁龙X Elite,高通向全球展示了全世界首个于终端侧运行的跨越70亿参数的年夜型多模态语言模子(LMM)。该模子可吸收文本及音频输入(如音乐、交通情况音频等),并基在音频内容天生多轮对于话。

以是,于集成为了Hexagon NPU的挪动终端上,会有如何的AI体验?以和它是怎样做到的?高通具体拆解了一个案例。

借助挪动终真个AI旅行助手,用户可以直接对于模子提出计划游览行程的需求。AI助手可以马上给到航班行程建议,而且经由过程语音对于话调解输出成果,末了经由过程Skyscanner插件创立完备航班日程。

这类一步到位的体验是怎样实现的?

第一步,用户的语音经由过程主动语音辨认(ASR)模子Whisper转化成文本。该模子有2.4亿个参数,重要于高通传感器中枢上运行;

第二步,使用Llama 2或者百川年夜语言模子基在文本内容天生文本答复,这一模子于Hexagon NPU上运行;

第三步,经由过程于CPU上运行的开源TTS(Text to Speech)模子将文本转化为语音;

末了一步,经由过程调制解调器技能举行收集毗连,利用Skyscanner插件完成订票操作。

行业井喷前夜,开发者需要抢占先机

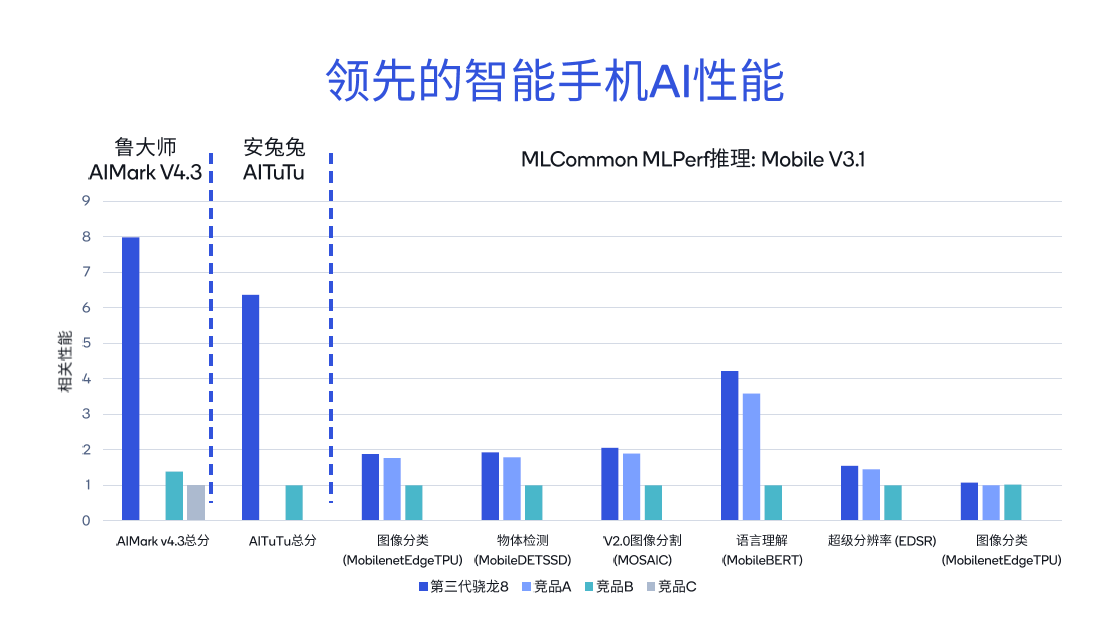

利用差别的东西测试骁龙及高通平台的AI机能体现,可以发明其患上分比同类竞品超出跨越几倍。从鲁巨匠AIMark V4.3基准测试成果来看,第三代骁龙8的总分相较竞品B超出跨越5.7倍,而相较竞品C超出跨越7.9倍。

于安兔兔AITuTu基准测试中,第三代骁龙8的总分比竞品B超出跨越6.3倍。针对于MLCo妹妹on MLPerf推理的差别子项,包括图象分类、语言理解以和超等分辩率等,也举行了详尽的比力。

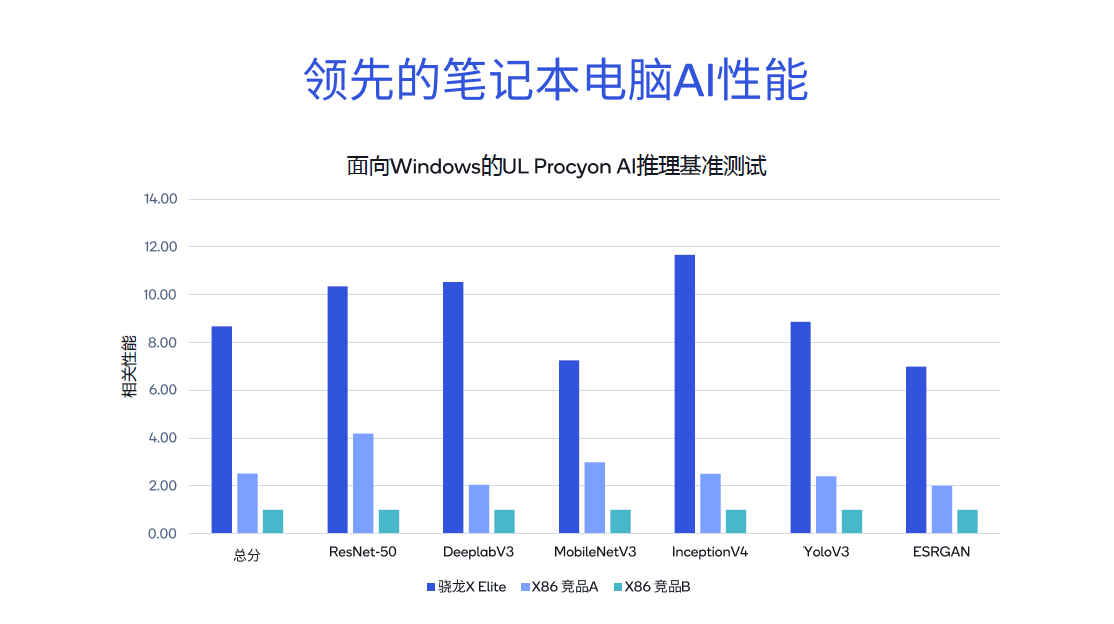

进一步对于比骁龙X Elite与其他X86架构竞品,于ResNet-50、DeeplabV3等测试中,骁龙X Elite体现出较着的领先职位地方,其基准测试总分别离是X86架构竞品A的3.4倍及竞品B的8.6倍。是以,于PC端,不管是运行Microsoft Copilot,还有是举行文档择要、文档撰写等天生式AI运用,体验都十分流利。

进一步对于比骁龙X Elite与其他X86架构竞品,于ResNet-50、DeeplabV3等测试中,骁龙X Elite体现出较着的领先职位地方,其基准测试总分别离是X86架构竞品A的3.4倍及竞品B的8.6倍。是以,于PC端,不管是运行Microsoft Copilot,还有是举行文档择要、文档撰写等天生式AI运用,体验都十分流利。

领先的AI机能不全是高通AI引擎的功绩,切当的说,高通对于AI厂商的赋能是全方位的。

领先的AI机能不全是高通AI引擎的功绩,切当的说,高通对于AI厂商的赋能是全方位的。

起首是高通AI引擎。它包括Hexagon NPU、Adreno GPU、高通Oryon CPU(PC平台)、高通传感器中枢及内存子体系。专门的工业设计、差别部件之间优良的协同,这款异构计较架构为终端侧产物提供了低功耗、高能效的开发平台。

基在进步前辈的硬件,高通又推出了AI软件栈(高通AI Stack)。这款产物的降生是为相识决AI开发中的恶疾——统一个功效,针对于差别平台要屡次开发,反复劳动。AI Stack撑持今朝所有的主流AI框架,OEM厂商及开发者可以于平台上创立、优化及部署AI运用,而且能实现“一次开发,全平台部署”,年夜年夜削减了研发职员的反复劳动。

图:高通AI软件栈帮忙开发者“一次开发,全平台部署” 来历:高通

此外,还有有高通于MWC2024上方才发布的AI Hub。AI Hub是一个包罗了近80个AI模子的模子库,此中既有天生式AI模子,也有传统AI模子,还有包括图象辨认或者脸部辨认模子,百川、Stable Diffusion、Whisper等模子。开发者可以从AI Hub中拔取想要利用的模子天生二进制插件,做到AI 开发的“即插即用”。

综合来讲,假如纵向看深度,高通于硬件(AI引擎)、软件(AI Stack)及素材库(AI Hub)三个维度周全加快厂商的AI开发进度。横向看笼罩广度,高通的产物已经经笼罩了险些所有的终端侧装备(第三代骁龙8撑持手机等终端,X Elite赋能AI PC产物)。

综合来讲,假如纵向看深度,高通于硬件(AI引擎)、软件(AI Stack)及素材库(AI Hub)三个维度周全加快厂商的AI开发进度。横向看笼罩广度,高通的产物已经经笼罩了险些所有的终端侧装备(第三代骁龙8撑持手机等终端,X Elite赋能AI PC产物)。

AI运用处在井喷前的酝酿期。

于教诲范畴,AI能针对于学生的进修能力及进度制订个性化的讲授方案;于医学范畴, AI可以用来掘客全新的抗生素类型;于养老方面,将来于一些社会老龄化问题比力严峻的地域,可以使用AI终端网络老年人家中的所有小我私家数据,从而帮忙预防紧迫医疗变乱。

之以是叫“井喷前”,恰是由于还有没有年夜范围部署。另外一方面,AI运用,作为最轻易让用户孕育发生粘性的产物之一,具备很强的先发上风效应。

AI产物开发者需要先行一步,早一些让用户体验本身的产物,及用户成立毗连,造就粘性,从而于竞争中占患上先机。

(文章转载自DeepTech深科技)

-球盟会